Back to IF3170 Inteligensi Artifisial

Topic

Questions/Cues

Apa itu PEAS?

Contoh PEAS untuk Taksi & Medis?

Apa saja properti Lingkungan Tugas?

Perbedaan properti lingkungan?

Apa saja tipe-tipe struktur Agent?

Bagaimana Simple Reflex Agent bekerja?

Apa kelebihan Model-based Agent?

Apa peran tujuan (Goal)?

Kapan Utility-based Agent digunakan?

Bagaimana Learning Agent berkembang?

Contoh level agent di Wumpus World?

Reference Points

- Modul: Intelligent Agent - Agent Types (IF3170)

Kerangka Kerja PEAS

PEAS adalah sebuah kerangka kerja (framework) yang digunakan untuk merumuskan masalah bagi seorang agent. Ini membantu kita mendefinisikan tugas agent dengan jelas. PEAS adalah singkatan dari:

Performance Measure (Ukuran Kinerja): Apa kriteria kesuksesan? Bagaimana kita mengukur keberhasilan agent?

Environment (Lingkungan): Di mana agent beroperasi? Apa saja kondisi eksternalnya?

Actuators (Aktuator): Perangkat apa yang dimiliki agent untuk bertindak di lingkungan?

Sensors (Sensor): Perangkat apa yang dimiliki agent untuk merasakan/mengamati lingkungan?

Contoh Analisis PEAS

Agent Performance Environment Actuators Sensors Taksi Otomatis Aman, cepat, legal, nyaman, memaksimalkan profit Jalan, lalu lintas lain, pejalan kaki, pelanggan Setir, gas, rem, sinyal, klakson Kamera, sonar, GPS, speedometer, keyboard Sistem Diagnosis Medis Pasien sehat, biaya minimal, menghindari tuntutan hukum Pasien, rumah sakit, staf medis Tampilan layar (pertanyaan, tes, diagnosis) Keyboard (untuk memasukkan gejala, temuan) Lingkungan Tugas (Task Environments)

Lingkungan tempat agent beroperasi dapat diklasifikasikan berdasarkan beberapa properti utama. Properti ini sangat menentukan desain agent yang paling cocok.

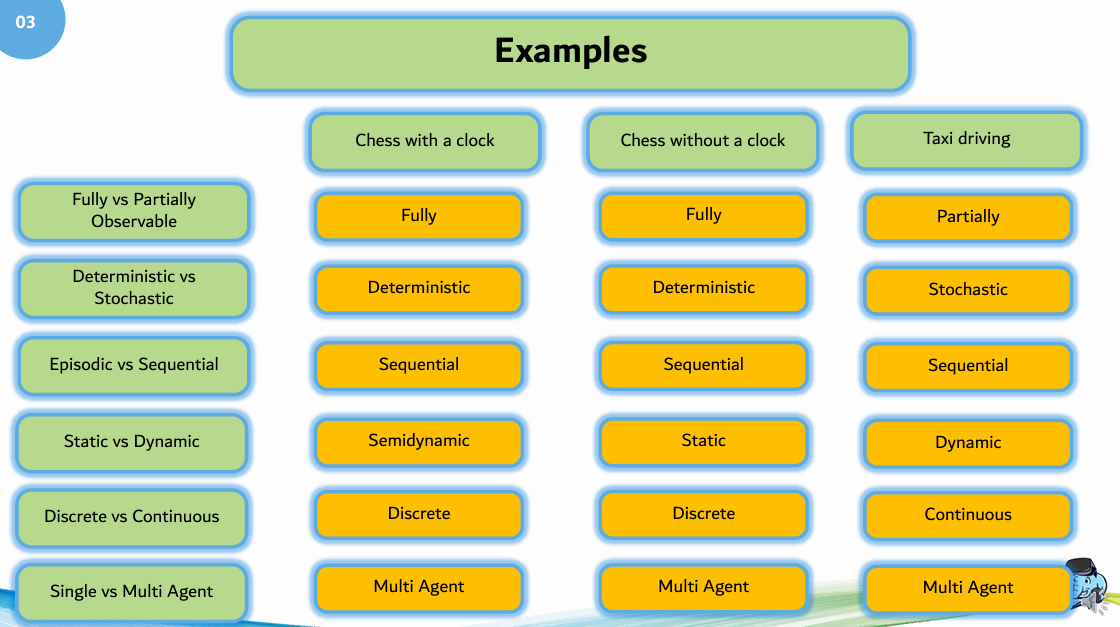

Fully vs Partially Observable: Jika sensor agent dapat mengakses keadaan lengkap lingkungan pada setiap waktu, maka lingkungan itu fully observable. Jika tidak (misalnya, ada informasi tersembunyi), maka partially observable.

Deterministic vs Stochastic: Jika keadaan lingkungan selanjutnya sepenuhnya ditentukan oleh keadaan sekarang dan aksi agent, maka lingkungan itu deterministic. Jika ada unsur ketidakpastian atau keacakan, maka stochastic (probabilistik).

Episodic vs Sequential: Dalam lingkungan episodic, pengalaman agent dibagi menjadi episode-episode atomik. Pilihan aksi di satu episode tidak memengaruhi episode berikutnya. Dalam lingkungan sequential, keputusan saat ini dapat memengaruhi semua keputusan di masa depan.

Static vs Dynamic: Lingkungan disebut dynamic jika dapat berubah saat agent sedang “berpikir” atau memproses. Jika lingkungan tidak berubah kecuali oleh aksi agent, maka disebut static. Semidynamic berarti lingkungan tidak berubah seiring waktu, tetapi skor kinerja agent bisa berubah.

Discrete vs Continuous: Jika ada jumlah persepsi (input/output) dan aksi yang terbatas dan terdefinisi dengan jelas, lingkungan itu discrete. Jika persepsi dan aksi berada dalam rentang nilai yang kontinu, maka continuous.

Single vs Multi-agent: Apakah agent beroperasi sendiri (single-agent) atau ada agent lain di lingkungan yang juga bertindak (multi-agent)?

Known vs Unknown: Jika agent familiar/tahu aturan akan lingkungannya, maka ia berada dalam lingkungan yang diketahui (Known). Sebaliknya pun berlaku.

Tipe-Tipe Struktur Agent

Program agent menerjemahkan persepsi menjadi aksi. Ada beberapa tipe dasar program agent, dari yang paling sederhana hingga paling kompleks.

Simple Reflex Agent: Agent ini hanya bereaksi terhadap persepsi saat ini, mengabaikan riwayat persepsi. Mereka bekerja berdasarkan aturan kondisi-aksi (condition-action rule): “jika kondisi X, maka lakukan aksi Y”. Cocok untuk lingkungan yang fully observable.

Model-based Reflex Agent: Agent ini mampu menangani lingkungan yang partially observable. Mereka memelihara model internal atau representasi dari keadaan dunia yang tidak bisa dilihat saat ini. Model ini diperbarui berdasarkan riwayat persepsi dan aksi.

Goal-based Agent: Selain memiliki model, agent ini memiliki informasi tujuan (goal). Mereka memilih aksi yang akan membawa mereka lebih dekat ke tujuan tersebut. Ini memungkinkan fleksibilitas yang lebih besar; jika tujuan berubah, perilakunya juga berubah. Keputusan seringkali melibatkan search dan planning.

Utility-based Agent: Agent ini tidak hanya memiliki tujuan, tetapi juga fungsi utilitas yang mengukur tingkat “kebahagiaan” atau preferensi terhadap suatu keadaan. Ketika ada beberapa cara untuk mencapai tujuan, agent akan memilih cara yang memberikan utilitas tertinggi. Ini berguna ketika ada tujuan yang saling bertentangan atau ketika ada ketidakpastian.

Learning Agent: Agent ini dapat beroperasi di lingkungan yang tidak diketahui dan menjadi lebih kompeten seiring berjalannya waktu. Terdiri dari empat komponen utama:

Learning Element: Bertanggung jawab untuk membuat perbaikan.

Performance Element: Bertanggung jawab untuk memilih aksi eksternal (ini adalah agent itu sendiri).

Critic: Memberikan umpan balik tentang seberapa baik kinerja agent.

Problem Generator: Menyarankan aksi eksplorasi yang akan menghasilkan pengalaman baru yang informatif.

Level Agent dalam Wumpus World

Wumpus World adalah sebuah gua yang terdiri dari kamar-kamar, berisi lubang (pit), Wumpus, dan emas. Ini adalah lingkungan pengujian klasik untuk agent.

Level 1: Problem Solving Agent: Agent ini memiliki peta lengkap gua (informasi semua state). Tugasnya adalah mencari jalur terpendek ke emas menggunakan algoritma pencarian seperti BFS, DFS, atau A*.

Level 2: Knowledge-based Agent: Agent tidak memiliki peta. Ia hanya memiliki pengetahuan dasar (aturan), misalnya “jika ada hembusan angin (breeze), maka ada lubang di dekatnya”. Agent menggunakan penalaran (reasoning) untuk menyimpulkan fakta baru dari apa yang ia persepsikan dan secara bertahap membangun pemahamannya tentang dunia. Solusinya dicari dengan premise deduction.

Level 3: Learning Agent: Agent tidak memiliki peta maupun pengetahuan dasar. Ia belajar dari pengalaman. Dengan bermain berkali-kali (dan mungkin mati beberapa kali), agent mengumpulkan data observasi dan menggunakan algoritma pembelajaran (misalnya, reinforcement learning) untuk akhirnya mempelajari aturan dunia, seperti “kotak di sebelah lubang itu berangin”. Setelah belajar, solusinya dicari dengan premise deduction.

Kerangka kerja PEAS digunakan untuk mendefinisikan masalah bagi seorang agent dengan jelas. Karakteristik lingkungan tugas (seperti observable, deterministic, static) sangat memengaruhi desain program agent yang dibutuhkan. Terdapat berbagai tipe struktur agent dengan kompleksitas yang meningkat, mulai dari Simple Reflex yang reaktif, Model-based yang memiliki state internal, Goal-based yang proaktif, Utility-based yang memaksimalkan kepuasan, hingga Learning Agent yang dapat beradaptasi dan meningkatkan kinerjanya melalui pengalaman.

Additional Information

Lebih Jauh tentang Properti Lingkungan

Stochastic vs. Deterministic: Perbedaan utamanya adalah pada prediktabilitas. Di dunia deterministik, jika Anda tahu aturannya, Anda bisa memprediksi masa depan dengan sempurna. Di dunia stochastic, bahkan jika Anda tahu aturannya (probabilitasnya), Anda tidak bisa memastikan hasilnya. Catur adalah deterministik, sementara permainan dadu adalah stochastic.

Static vs. Dynamic: Contoh lingkungan statis adalah teka-teki silang; teka-teki itu tidak akan mengubah dirinya sendiri saat Anda berpikir. Mengemudi adalah contoh utama lingkungan dinamis; mobil lain terus bergerak bahkan saat Anda tidak melakukan apa-apa.

Hubungan Antar Tipe Agent

Tipe-tipe agent ini bisa dilihat sebagai sebuah evolusi, di mana setiap tipe berikutnya menambahkan kapabilitas baru di atas tipe sebelumnya:

Model-based = Simple Reflex + Model Internal (State)

Goal-based = Model-based + Tujuan (Goal)

Utility-based = Goal-based + Fungsi Utilitas

Learning Agent adalah sebuah meta-tipe yang bisa diterapkan pada semua tipe di atas untuk memungkinkan mereka beradaptasi.

Eksplorasi Mandiri: Klasifikasi Lingkungan

Coba klasifikasikan lingkungan tugas untuk permainan-permainan berikut berdasarkan properti yang telah dibahas:

Catur: Fully observable, deterministic, sequential, static, discrete, multi-agent.

Poker: Partially observable (kartu lawan), stochastic (pembagian kartu), sequential, static, discrete, multi-agent.

Video Game Real-Time Strategy (RTS): Partially observable (“kabut perang”), stochastic (tindakan lawan), sequential, dynamic, discrete (bisa diperdebatkan, cenderung ke arah continuous), multi-agent.